Il progredire dello sviluppo dell’intelligenza artificiale (AI) sta rivoluzionato numerosi settori, dall’assistenza sanitaria alla mobilità, dall’automazione industriale alla finanza. Tuttavia, dietro i risultati entusiasmanti raggiunti si cela un aspetto spesso trascurato: il consumo energetico.

Il costo energetico degli Algoritmi di Intelligenza artificiale è un elemento da non sottovalutare soprattutto alla luce delle emissioni globali di CO2 che portano con sé evidenti effetti sul cambiamento climatico in corso.

La crescente domanda di calcolo

L’AI richiede enormi quantità di calcolo per addestrare modelli complessi e gestire flussi di dati massicci. I progressi nella ricerca hanno portato all’adozione sempre più diffusa di algoritmi di apprendimento profondo (deep learning), che richiedono risorse computazionali considerevoli. Stime recenti calcolano che entro il 2030 l’AI potrebbe rappresentare fino al 4% del

consumo di energia elettrica globale. Allo stato attuale Google afferma che dal 10% al 15% del loro consumo energetico totale è dovuto alla loro AI. Siamo nell’ordine di 2,3 TWh all’anno. Da una delle prime analisi volte a quantificare la domanda di energia che si sta utilizzando, come recentemente pubblicata sulla rivista Joule, emerge che il mantenimento dell’attuale livello tendenziale in termini di capacità e adozione dell’intelligenza artificiale porterà Nvidia a immettere sul mercato 1,5 milioni di unità server che, funzionanti a pieno regime, consumeranno almeno 85,4 TWh di elettricità all’anno: più del consumo annuo di molti piccoli paesi.

Potenza assorbita: il ruolo dei Data Center

I data center sono i pilastri dell’infrastruttura informatica moderna e giocano un ruolo cruciale nell’esecuzione degli algoritmi di AI. Queste strutture, spesso composte da migliaia di server, consumano quantità significative di energia per raffreddare gli impianti e mantenere le operazioni in funzione. Come è noto dalle leggi della fisica il consumo di energia è fortemente influenzato dalla complessità delle operazioni che devono essere svolte e dal tempo richiesto per portarle a termine, elementi che AI sfrutta in modo intensivo a causa dell’elevato livello di risorse richieste degli algoritmi.

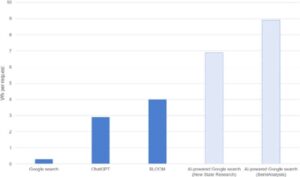

Dati interessanti ci vengono forniti dalle ricerche condotte da Alex de Vries, data scientist presso la banca centrale dei Paesi Bassi e Ph.D. alla Vrije University Amsterdam, che studia i costi energetici delle tecnologie emergenti, ed è noto soprattutto per aver lanciato l’allarme sugli enormi costi energetici del mining e delle transazioni di criptovalute. Egli ha stimato che l’utilizzo dell’intelligenza artificiale generativa come ChatGPT per ogni ricerca fatta su Google richiederebbe più di 500.000 server A100 HGX di Nvidia, per un totale di 4,1 milioni di elaborazioni unità grafiche o GPU. Sarebbe necessaria una di potenza di 6,5 kW per server con un consumo giornaliero di elettricità di 80 GWh e un consumo annuale di 29,2 TWh. De Vries afferma che con gli attuali livelli tecnologici di hardware e software risulta improbabile un’adozione così dilagante dell’AI a causa degli elevati costi e dell’effettiva disponibilità di server. In sintesi sono i fattori tecnologici ed economici che potrebbero porre freno all’espansione dell’utilizzo pervasivo dell’AI e quindi al problema del consumo energetico.

L’impatto ambientale: emissioni di CO2

Il consumo energetico degli algoritmi di AI non è solo una questione di costi operativi, ma anche di impatto ambientale. L’energia utilizzata per alimentare i data center spesso proviene da fonti non rinnovabili, contribuendo così alle emissioni di

CO2 e all’accelerazione dei cambiamenti climatici. È dunque fondamentale valutare e mitigare queste emissioni per garantire uno sviluppo sostenibile dell’AI. Secondo uno studio condotto da Carbon Trust, un’organizzazione no profit specializzata in

sostenibilità, il funzionamento continuo di un data center di medie dimensioni per un anno può generare emissioni di CO2 pari a diverse centinaia di tonnellate, principalmente a causa dell’uso di energia elettrica da fonti non rinnovabili.

Potenza assorbita degli algoritmi di AI

La potenza assorbita dagli algoritmi di AI dipende da diversi fattori, tra cui la complessità del modello, la dimensione del set di dati e la frequenza di addestramento o inferenza. La domanda di energia necessaria per l’addestramento è molto più elevata

e concentrata rispetto alle tradizionali applicazioni dei data center elementi importanti a cui fare riferimento nella fase di dimensionamento degli impianti. Considerando la fase di addestramento del modello, che è anche la più studiata, l’analisi svolta dai ricercatori di Google e dell’Università di Berkeley in California (Patterson et al., 2021) riporta che i valori del consumo energetico richiesto per l’addestramento di alcuni modelli di AI si aggirano intorno al centinaio di MWh, con un picco di 1.287 MWh per GPT-3. Valori impressionanti soprattutto perché associati alla sola fase di addestramento a cui poi vanno sommati i valori di assorbimento necessari al funzionamento degli algoritmi per ogni richiesta.

Strategie per la Riduzione dell’Impatto Ambientale

Ottimizzazione dell’Algoritmo

Un approccio chiave per ridurre il consumo energetico è ottimizzare gli algoritmi stessi. Ciò può includere la progettazione di modelli più efficienti in termini di calcolo o l’implementazione di algoritmi più leggeri che richiedono meno risorse per l’addestramento e l’inferenza.

Utilizzo di Energia Rinnovabile

Promuovere l’adozione di fonti energetiche rinnovabili per alimentare i data center può ridurre in modo significativo l’impatto ambientale dell’AI.

Consolidamento delle Risorse

Il consolidamento delle risorse computazionali attraverso l’adozione di tecnologie come la virtualizzazione e il cloud computing può contribuire a ottimizzare l’utilizzo dell’energia nei data center. Riducendo il numero di server inutilizzati o sottoutilizzati, si può migliorare il consumo complessivo di energia.

Conclusioni

Il consumo energetico degli algoritmi di intelligenza artificiale rappresenta una sfida significativa, sia in termini di costi che di impatto ambientale. Misurare e comprendere questo consumo è essenziale per adottare strategie efficaci di mitigazione. Ottimizzare gli algoritmi, utilizzare energie rinnovabili e consolidare le risorse sono solo alcune delle azioni che possono essere intraprese per ridurre l’impatto ambientale dell’AI e garantire uno sviluppo sostenibile nel lungo termine. Tutto questo nel contesto in cui gli straordinari successi ottenuti nel campo delle tecnologie digitali, mi riferisco alla miniaturizzazione ed alla ottimizzazione, hanno fatto sì che si potesse consumare meno energia per effettuare le medesime operazioni ad una velocità di gran lunga superiore. Non possiamo poi trascurare il fattore economico della riduzione dei costi che ha permesso l’enorme ed inarrestabile pervasività di queste tecnologie in tutti gli ambiti della nostra vita quotidiana. Grazie a questi progressi, il consumo energetico globale dell’ICT non ha fatto che crescere e l’avvento della AI non è altro che un ulteriore tassello di questo mosaico che richiede una particolare attenzione visti i numeri in gioco, ma è pur sempre una parte di un sistema che all’apparenza e totalmente green mentre in realtà non lo è proprio.

“Sono i fattori tecnologici ed economici che potrebbero porre freno all’espansione dell’utilizzo pervasivo dell’AI e quindi al problema del consumo energetico”